L’économie américaine est officiellement sortie de la Grande Récession en juin 2009. L’expansion qui s’est amorcée à cette date ne s’est, jusqu’à présent, pas interrompue, si bien que les Etats-Unis auront connu, quoiqu’il arrive, l’une des plus longues expansions de son histoire. Depuis le début de la reprise, le taux de chômage a régulièrement diminué et atteint des niveaux particulièrement faibles : il est passé sous les 4 % ces derniers mois, soit un niveau inférieur à celui qu’il atteignait à la veille de la crise financière. La durée exceptionnelle de l’expansion et la faiblesse du taux de chômage alimentent les craintes d’une forte accélération de l’inflation. Et pourtant, cette dernière reste à un faible niveau. Elle se comporte à peu près pareillement dans d’autres pays développés, en particulier la zone euro (même s’il faut avouer que la reprise a été moins robuste au sein de celle-ci). Jared Bernstein (2017) y voit « l’énigme numéro une en économie ».

Ce n’est pas la première fois que le comportement de l’inflation surprend les économistes. Ces derniers ont souvent étudié le lien entre inflation et activité au prisme de la courbe de Phillips, mais le comportement de l’inflation lors de la Grande Récession, puis lors de la subséquente reprise a semblé infirmé une telle relation. En effet, malgré la forte hausse du chômage aux Etats-Unis et dans plusieurs pays développés, l’inflation y est restée relativement stable, alors qu’une courbe de Phillips traditionnelle aurait suggéré qu’une forte déflation apparaisse dans un tel contexte. Certains ont alors parlé d’une « désinflation manquante » (missing deflation). Pour l’expliquer, certains ont suggéré que la crédibilité des banques centrales aurait permis d’ancrer les anticipations d’inflation ; d’autres ont évoqué un aplatissement de la courbe de Phillips [FMI, 2013]. Pour d’autres encore, comme Larry Summers (2017) et The Economist (2017), la courbe de Phillips serait tout simplement morte. Alan Blinder (2018) suggère qu’elle est peut-être « juste partie en vacances », tandis qu’Olivier Blanchard (2016) la croit toujours vivante, mais précise qu’elle n’a jamais été bien fébrile : la relation n’a jamais été bien robuste.

Deux nouvelles lignes de défense de la courbe de Phillips ont été récemment proposées. Dans la première, Laurence Ball et Sandeep Mazumder (2019) estiment que le comportement de l’inflation est plus facile à comprendre si nous divisons l’inflation globale en une inflation sous-jacente et un résidu transitoire et si l’inflation sous-jacente est mesurée, comme le préconisaient Michael Bryan et Stephen Cecchetti (1994), par la médiane pondérée des taux d’inflation des différents secteurs. L’inflation sous-jacente est habituellement mesurée en prenant le taux d’inflation et en retranchant de celui-ci les prix des aliments et de l’énergie. Ces derniers sont en effet très volatiles, mais d’autres secteurs connaissent aussi d’amples variations des prix qui influencent fortement le taux d’inflation global. La médiane pondérée est moins volatile que la mesure traditionnelle de l’inflation sous-jacente, car elle élimine les amples variations des prix dans toutes les industries.

Ball et Mazumder démontrent l’opportunité d’utiliser la médiane pondérée en étudiant le comportement de l’inflation en 2017 et au début de l’année 2018. Au cours de cette période, la mesure traditionnelle de l’inflation sous-jacente suggérait que celle-ci avait chuté, chose que le comité de politique monétaire de la Fed ne parvenait pas à comprendre. Mais la médiane pondérée ne chuta pas autant au cours de cette période, parce qu’elle excluait la forte baisse des prix que connurent plusieurs secteurs de l’économie.

Pour Ball et Mazumder, la courbe de Phillips est bien vivante aux Etats-Unis, mais elle n’explique que l'inflation sous-jacente. Une courbe de Phillips reliant la médiane pondérée au chômage apparaît clairement dans les données pour la période allant de 1985 à 2017 et il n’y a pas de rupture dans cette relation en 2008.

De leur côté, Olivier Coibion et Yuriy Gorodnichenko (2015) avaient suggéré que l’absence de déflation durant la Grande Récession étant tout à fait compatible avec la courbe de Phillips, à condition que celle-ci soit augmentée des anticipations. En l’occurrence, la hausse des prix du pétrole entre 2009 et 2011 aurait amené les ménages à relever leurs anticipations d’inflation, ce qui aurait empêché l’inflation de ralentir autant que l’aurait mécaniquement impliqué la chute de l’activité.

GRAPHIQUE 1 La courbe de Phillips augmentée des anticipations

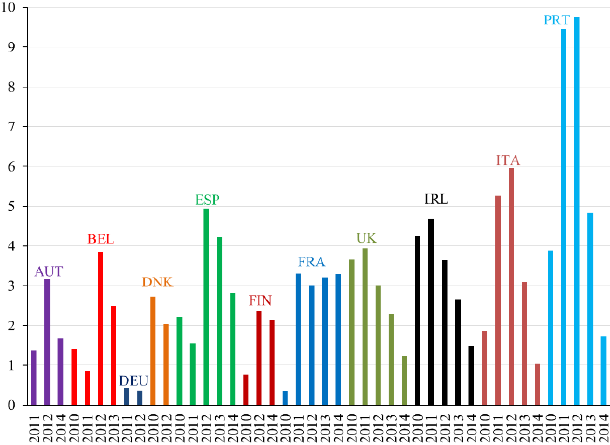

Olivier Coibion, Yuriy Gorodnichenko et Mauricio Ulate (2019) ont compilé les données relatives à plusieurs économies pour lesquelles des enquêtes ont été réalisées depuis suffisamment longtemps auprès des entreprises ou des ménages, en l’occurrence 17 pays développés et la zone euro prise dans son ensemble. Ils mettent en évidence une relation négative et robuste entre l’écart d’inflation (c’est-à-dire l’écart entre l’inflation observée et l’inflation anticipée) et l’écart de chômage (c’est-à-dire l’écart entre le taux de chômage observé et le taux de chômage naturel) : lorsque l’inflation tend à être supérieure à l’inflation anticipée dans un pays, alors le taux de chômage tend à être inférieur à son niveau naturel (cf. graphique 1). Par contre, il n’y a pas de véritable relation entre les variations de l’inflation et les écarts de chômage, ce qui amène Coibion et ses coauteurs à douter que le lien entre l’inflation et le degré de mollesse de l’activité puisse être décrit par une courbe de Phillips accélérationniste à la Friedman (1968) : les anticipations d’inflation jouent un rôle crucial, mais il ne s’agit pas d’anticipations adaptatives.

GRAPHIQUE 2 Ecarts d’inflation américain et mondial

Coibion et ses coauteurs estiment que cette relation permet de juger du degré de mou dans l’activité économique : il est possible d’avoir une idée de l’écart de chômage en déterminant l’écart d’inflation. Par exemple, si l’inflation est bien en-deçà de son niveau anticipé, il est peu probable que le chômage soit en-deçà de son niveau naturel. En utilisant les données qu’ils ont collectées sur les anticipations d’inflation, Coibion et ses coauteurs cherchent alors à estimer l’écart d’inflation mondial, c’est-à-dire la composante commune dans l’écart entre l’inflation observée et l’inflation anticipée que l’on observe dans les pays développés. L’écart d’inflation aux Etats-Unis et l’écart d’inflation mondial présentent les mêmes évolutions (cf. graphique 2). Durant l’essentiel des années deux mille, ils ont été nuls ou proches de zéro, puis ils ont commencé à devenir négatifs au début de la Grande Récession. Les niveaux d’inflation se sont davantage éloignés de leurs niveaux anticipés entre 2011 et 2014. Depuis le point bas qu’ils ont atteint au milieu des années deux mille dix, les écarts d’inflation se sont régulièrement réduits, suggérant que les pressions déflationnistes qui se sont manifestées dans le sillage de la Grande Récession se sont pour l’essentiel dissipées. Pour autant, les écarts d’inflation restent négatifs, ce qui suggère que l’activité reste molle non seulement aux Etats-Unis, mais aussi dans la plupart des autres pays développés. Autrement dit, les écarts de production se referment, mais il y a encore du mou dans l’activité économique. Par conséquent, l’inflation ne semble pas sur le point de fortement s’accélérer, du moins pas tant que les anticipations d’inflation ne soient pas fortement révisées à la hausse ou que le chômage ne chute pas brutalement.

Références

BLANCHARD, Olivier (2016), « The US Phillips curve: Back to the 60s? », PIIE, policy brief, n° 16-1.

The Economist (2017), « The Phillips Curve may be broken for good », 1er novembre.

FMI (2013), « The dog that didn’t bark: Has inflation been muzzled or was it just sleeping », World Economic Outlook, chapitre 3, avril. Traduction française, « Telle l’histoire du chien qui n’a pas aboyé : l’inflation a-t-elle été muselée, ou s’est-elle simplement assoupie? », Perspectives de l’économie mondiale, chapitre 3.

FRIEDMAN, Milton (1968), « The role of monetary policy », in American Economic Review, vol. 58.

/image%2F1455320%2F20160828%2Fob_7355b6_jesse-pinkman-illusio-3.jpg)