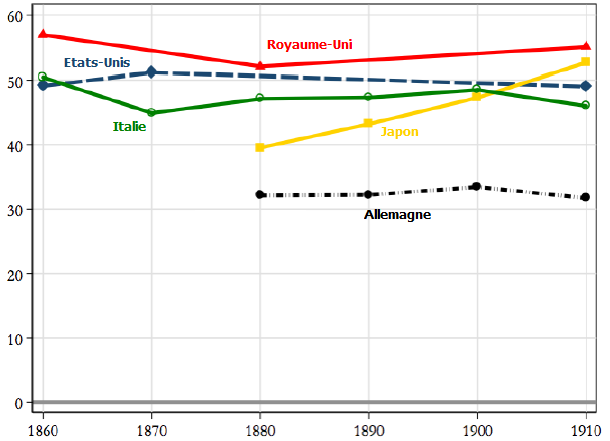

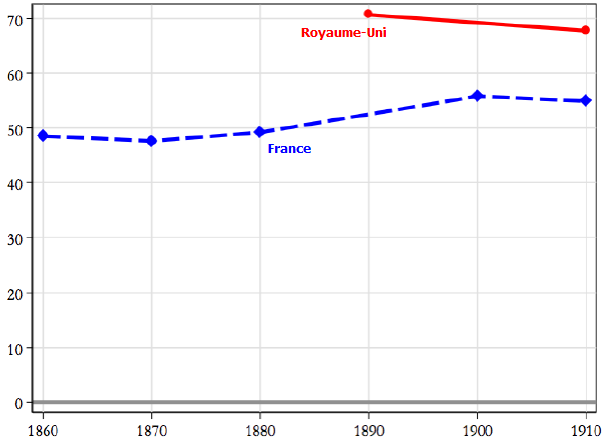

L’économie américaine (pour ne pas dire l’essentiel des pays développés) présente une situation paradoxale. D’un côté, les systèmes utilisant une intelligence artificielle égalent ou surpassent déjà les capacités humaines dans des domaines toujours plus nombreux, ce qui permet de nouvelles avancées dans d’autres secteurs. On devrait par conséquent s’attendre à une poursuite, voire à une accélération, de la croissance de la productivité et donc des niveaux de vie. Une telle prévision optimiste, promesse d’une hausse soutenue des profits, contribue d’ailleurs sûrement à soutenir les cours boursiers. Pourtant, la croissance de la productivité mesurée a été divisée par deux au cours de la dernière décennie. Ce ralentissement, qui s’est amorcé avant qu’éclate la crise financière mondiale, est un phénomène généralisé : il a initialement touché les pays développés, puis les grands pays émergents. Il contribue par conséquent à contenir la hausse des niveaux de vie : par exemple, la majorité des Américains ont vu leur revenu réel stagné depuis la fin des années quatre-vingt-dix.

Bref, nous nous retrouvons face à une variante du paradoxe de la productivité mis en avant par Robert Solow (1987) : nous voyons partout les nouvelles technologies, sauf dans les statistiques de productivité. Erik Brynjolfsson, Daniel Rock et Chad Syverson (2017) en ont proposé quatre explications possibles.

Selon une première explication, l’optimisme que suscitent les nouvelles technologies est tout simplement infondé. Celles-ci ont peut-être des effets visibles sur certains secteurs en particulier, mais il est possible que leurs effets au niveau agrégé soient diffus. Si c’est effectivement le cas, l’optimisme risque de ne pas perdurer et de laisser place à la seule déception. Une telle révision des anticipations se traduira alors par une chute des valeurs boursières.

Selon une deuxième explication, avancée notamment par Joel Mokyr (2014), il est possible que la croissance de la productivité soit restée soutenue, voire ait accélérée, mais que cela ait échappé aux indicateurs. Bref, le ralentissement de la productivité que l’on a observé cette dernière décennie est peut-être illusoire ; la population tire peut-être davantage de gains des nouvelles technologies qu’on ne le pense. Cela s’expliquerait par le fait que les indicateurs habituels ne sont pas adaptés pour mesurer la valeur ajoutée des récentes innovations. Par exemple, les consommateurs passent une grande partie de leur temps sur leurs smartphones et les réseaux sociaux en ligne, mais comme ces innovations ont un coût monétaire relativement faible, elles représentent une faible part du PIB relativement à l’utilité qu’elles procurent. Pourtant, plusieurs études, notamment celles de Roberto Cardarelli et Lusine Lusinyan (2015), Chad Syverson (2016) et David Byrne et alii (2016) suggèrent que les problèmes de mesure ne peuvent être la principale explication derrière le ralentissement de la croissance de la productivité : après tout, le PIB ne reflète peut-être pas tous les bénéfices des technologies actuelles, mais il ne reflétait peut-être pas non plus tous les bénéfices des technologies passées.

Selon une troisième explication, les nouvelles technologies génèrent peut-être déjà de nombreux gains, mais ces derniers pourraient être captés par une fraction de l’économie, si bien que leurs effets sur la croissance de la productivité moyenne est faible au niveau agrégé et qu’ils sont nuls pour le travailleur médian. La nature rivale des nouvelles technologies pourrait entraîner une sorte de « ruée vers l’or » à travers laquelle les compétiteurs adoptent des pratiques pour obtenir les gains ou en bloquer l’accès aux autres, c’est-à-dire des pratiques nuisibles pour le reste de l’économie, qui annulent au niveau agrégé les bénéfices des innovations. Une telle hypothèse est cohérente avec plusieurs constats empiriques : les écarts de productivité entre les entreprises les plus avancées et les entreprises moyennes semblent s’être creusés au sein de chaque secteur ces dernières années ; une poignée de « firmes superstars » capte une part de marché de plus en plus grande (Autor et alii, 2017), etc. Certains, comme Jan De Loecker et Jan Eeckhout (2017) ou Germán Gutiérrez et Thomas Philippon (2017), s’inquiètent ainsi de voir la hausse de la concentration dans les différents secteurs et la perturbation résultante du pouvoir de marché des différents agents entraîner des pertes de bien-être au niveau agrégé. En outre, notamment pour cette raison, le revenu total continue peut-être d’augmenter, mais le revenu moyen stagne avec l’accroissement des inégalités.

Selon une quatrième explication, les espoirs ne sont peut-être pas trop optimistes et les indicateurs statistiques n’ont peut-être pas tort : il se pourrait que les gains tirés des nouvelles technologies soient réels et massifs, mais qu’ils ne se sont pas encore manifestés. D’une part, il est possible qu’il faille beaucoup de temps avant que le stock de nouvelles technologies ait atteint une taille suffisante pour déployer tous leurs effets. D’autre part, il est possible que des investissements connexes soient nécessaires pour que le potentiel de ces technologies se concrétise et qu’il faille du temps pour identifier et mettre en œuvre ces investissements. C’est peut-être surtout des investissements dans des actifs intangibles et non des actifs physiques que les nouvelles technologies nécessitent : l’acquisition de certaines compétences, une refonte de l’organisation du travail, etc. En fait, il se pourrait que le délai soit d’autant plus long que la technologie est susceptible de bouleverser l’économie.

Même si les autres explications sont plausibles et cohérentes avec certaines preuves empiriques, c’est la dernière que Brynjolfsson et ses coauteurs privilégient. La (faiblesse de la) croissance actuelle de la productivité n’indique en rien quel sera le rythme de sa croissance future : la croissance de la productivité au cours d’une décennie n’a pas de significatif pouvoir prédictif pour celle de la décennie suivante. Dans la mesure où la croissance de la productivité totale des facteurs est « une mesure de notre ignorance », il n’est pas étonnant que ce résidu ne puisse être prévu à partir de ses valeurs passées.

Références

MOKYR, Joel (2014), « Secular stagnation? Not in your life », in voxEU.org, 11 août.

SOLOW, Robert (1987), « We'd better watch out », in New York Times Book Review.

/image%2F1455320%2F20160828%2Fob_7355b6_jesse-pinkman-illusio-3.jpg)