Le taux de chômage n’a pas réagi de la même manière, d’un pays à l’autre, lors de la crise financière mondiale. Par exemple, il demeure aux Etats-Unis toujours cinq points de pourcentage au-dessus de son niveau d’avant-crise, tandis que le chômage ne s’est qu’à peine dégradé au Royaume-Uni, voire n’a qu’à peine changé en Allemagne, malgré de plus larges contractions du PIB, alors que ces deux derniers pays ont connu une plus forte contraction de leur PIB.

Arthur Okun (1962) avait décelé une relation relativement stable entre les variations du chômage et celles du PIB, une relation qui reçut par la suite le nom de loi d’Okun : lorsque la croissance de la production est inférieure à celle attendue, le chômage augmente. Typiquement, aux Etats-Unis, si le taux de croissance du PIB réel diminue de 2 points de pourcentage par rapport à sa tendance de long terme, alors le taux de chômage s’élève d’environ 1 point de pourcentage. La loi d’Okun s’était révélée extrêmement stable aux Etats-Unis, si bien que les conjoncturistes ont souvent utilisé le taux de chômage pour réaliser des prévisions de croissance ou se sont au contraire basés sur les chiffres de croissance pour prévoir l’évolution du chômage.

Or, lors de la Grande Récession, le chômage s’est accru bien plus amplement que ne le suggéraient les données qui étaient alors disponibles, ce qui a amené beaucoup à s’interroger si la loi d’Okun était toujours pertinente pour les prévisions de chômage. Les révisions ultérieures des données montrent que la relation entre le PIB et le chômage suivit un schéma conjoncturel relativement similaire à celui observé lors des précédents épisodes de récessions et de reprises. Laurence Ball, Daniel Leigh et Prakash Loungani (2013) et Mary Daly, John Fernald, Òscar Jordà et Fernanda Nechio (2014b) ont ainsi montré que la loi d’Okun était restée valide lors de la Grande Récession et lors de la subséquente reprise, suggérant que si le chômage persistait à un niveau élevé dans plusieurs pays avancés, c’est tout simplement en raison du faible rythme de croissance dans ces derniers.

Mary Daly, John Fernald, Òscar Jordà et Fernanda Nechio (2014a) ont utilisé la loi d’Okun pour déterminer comment les entreprises et les marchés du travail ont réagi à la crise financière mondiale. En l’occurrence, les entreprises peuvent répondre à un choc de demande en faisant varier le nombre de travailleurs, le nombre d’heures travaillées par travailleur ou encore leur productivité. Cela dépendra de multiples facteurs, notamment des lois et institutions qui affectent la capacité des employeurs à embaucher et licencier du personnel et à modifier le temps de travail ou encore du processus de négociations. L’ajustement dépendra aussi de la persistance du choc de demande : si les employeurs interprètent la contraction de la demande comme permanente, ils seront incités à réduire le nombre de travailleurs ; si le choc est au contraire perçu comme temporaire, les employeurs veilleront à « thésauriser » la main-d’œuvre pour que les entreprises puissent immédiatement augmenter leur production lorsque surviendra la reprise. La productivité peut également varier lors d’une chute de la demande, notamment si les entreprises thésaurisent la main-d’œuvre, si le cadre institutionnel empêche de réduire le temps de travail ou si l'intensification de la concurrence incite les entreprises à réduire leurs coûts.

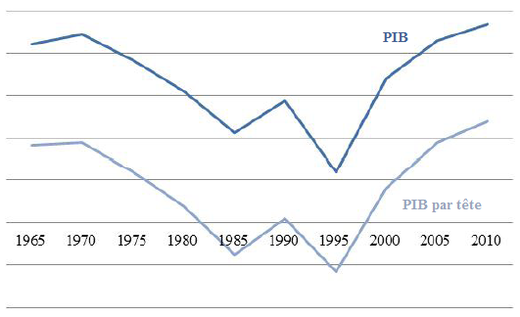

GRAPHIQUE Coefficients d'Okun

source : Daly et alii (2014a)

Daly et alii ont estimé le coefficient d’Okun pour une quinzaine de pays (cf. graphique) ; celui-ci mesure combien la production tend à varier, par rapport à sa tendance, lorsque le taux de chômage augmente d’un point de pourcentage. Le coefficient d’Okun est généralement négatif. En outre, plus sa valeur absolue est élevée, moins le chômage réagit à la conjoncture. Avant la Grande Modération, une hausse d’un point de pourcentage du taux de chômage était typiquement associée à un déclin d’environ 3 points de pourcentage du taux de croissance de la production, ce qui suggère que la production s’ajustait face aux chocs autrement qu’à travers le chômage. Le coefficient d’Okun moyen pour l’ensemble des 15 pays étudiés a fortement diminué durant les années quatre-vingt-dix et deux mille et les différences entre pays se sont considérablement réduites. Cette convergence des coefficients d’Okun pourrait notamment s’expliquer par la mondialisation, la plus grande mobilité de la main-d’œuvre, la libéralisation des relations salariés-employeurs et la diminution de la protection de l’emploi. Ces différents facteurs ont accru la flexibilité des marchés du travail et des produits, si bien que lorsque la production variait, l’ajustement passait de plus en plus par l’emploi et se répercutait donc de plus en plus sur le taux de chômage.

La crise financière mondiale a mis un terme à cette convergence. Le coefficient d’Okun est revenu à des niveaux qui n’avaient pas été observés depuis les années quatre-vingt. Sauf aux Etats-Unis et en Nouvelle-Zélande, sa valeur absolue a fortement augmenté lors de la Grande Récession, en particulier au Royaume-Uni et en Allemagne. Les coefficients d’Okun se sont également fortement dispersés.

Mary Daly et ses coauteurs ont décomposé la relation d’Okun en considérant que la croissance de la production est la somme de la croissance du nombre de travailleurs, la croissance du nombre d’heures par travailleur et la croissance de la productivité. Aux Etats-Unis, le nombre d’heures travaillées par travailleur est procyclique : il tend à chuter lorsque le chômage s’élève durant un ralentissement. Dans d’autres pays, notamment la France, l’Allemagne et l’Italie, les heures par travailleur tendent à s’élever durant les différents ralentissements de l’activité qui ont eu lieu avant la Grande Récession, ce qui suggère que la main-d’œuvre était utilisée plus intensivement lors de ces épisodes. En ce qui concerne la productivité, certaines études ont suggéré que la cyclicité de la productivité aux Etats-Unis avait changé de signe : la productivité américaine était tout d’abord procyclique, puis elle est devenue contracyclique. D’autres pays ont également présenté une productivité contracyclique depuis le milieu des années quatre-vingt-dix. A l’inverse, dans des pays comme l’Allemagne, la France ou l’Italie, la productivité était procyclique : elle avait tendance à fortement chuter lorsque le taux de chômage s’élevait.

Durant la Grande Récession et lors de la reprise qui l’a suivie, les pays ont ajusté les trois facteurs, mais ils n’ont pas toujours privilégié le même. A la différence des précédents ralentissements de l’activité, les entreprises se sont davantage appuyées sur le temps de travail pour ajuster leur production. Parallèlement à la hausse du chômage, tous les pays ont réduit le nombre d’heures travaillées par travailleur et certains l’ont même très fortement réduit. L’ajustement aux Etats-Unis apparaît semblable aux précédents : les hausses du chômage étaient associées à une réduction de l’emploi, à une chute la durée du travail et à une légère hausse de la productivité. Au Royaume-Uni, l’emploi, la durée du travail et la productivité réagirent bien plus lors de la Grande Récession qu’ils ne le firent lors des précédents ralentissements de l’activité. La principale différence entre les Etats-Unis et le Royaume-Uni est principalement l’ajustement de la productivité. En Allemagne, ce sont essentiellement le nombre d’heures travaillées par travailleur et la productivité qui réagirent lors de la Grande Récession, en raison notamment d’une législation qui permet aux employeurs d’ajuster plus facilement la durée du travail. Cela explique pourquoi le taux de chômage a faiblement varié en Allemagne lors de la crise et de la reprise, alors même que la production connaissait de fortes variations. Les dynamiques observées au Royaume-Uni et aux Etats-Unis pourraient refléter des différences dans les modèles sociaux amenant les entreprises britanniques à privilégier le maintien de l’emploi et les entreprises américaines à privilégier le maintien des salaires. Dans tous les cas, les moyens d’ajustement privilégiés par les entreprises pour faire face à la Grande Récession ont profondément façonné la trajectoire du taux de chômage.

Références

BALL, Laurence, Daniel LEIGH & Prakash LOUNGANI (2013), « Okun’s law: Fit at fifty? », National Bureau of Economic Research, working paper, n° 18668.

DALY, Mary C., John G. FERNALD, Òscar JORDÀ, Fernanda NECHIO (2014a), « Labor markets in the global financial crisis: The good, the bad and the ugly », Federal Reserve Bank of San Francisco, working paper, n° 2014-10.

OKUN, Arthur (1962), « Potential GNP: Its Measurement and Significance », American Statistical Association, Proceedings of the Business and Economics Statistics Section, pp. 98–104.

/image%2F1455320%2F20160828%2Fob_7355b6_jesse-pinkman-illusio-3.jpg)